Проверка прав доступа ПС к содержимому сайта

И вновь приветствую! В продолжение предыдущей темы я бы хотел озвучить такой аспект, как проверка прав доступа поисковых роботов к страницам сайта. Иными словами имеет ли право поисковый бот индексировать страницу и размещать ее в результатах поиска.

Для чего это нужно и где может пригодиться? Главное практическое применение — проверка директив файла robots.txt, закрывающих доступ к разделам или отдельным страницам сайта, т.е. идет проверка разрешено индексировать страницу или нет. Кроме robots могут применяться и другие методы для ограничения доступа, например .htaccess, мета-тег noindex.

Иногда так случается, что начинающий автор блога или администратор сайта не до конца разобрался с составлением роботса и не уверен все ли правильно он сделал — на помощь приходят удобные инструменты для проверки. Давайте разберемся на примерах, а в качестве этих инструментов сегодня выступают Анализ robots.txt и Просмотреть как Googlebot в Яндекс и Гугле соответственно.

Анализ robots.txt в Яндекс

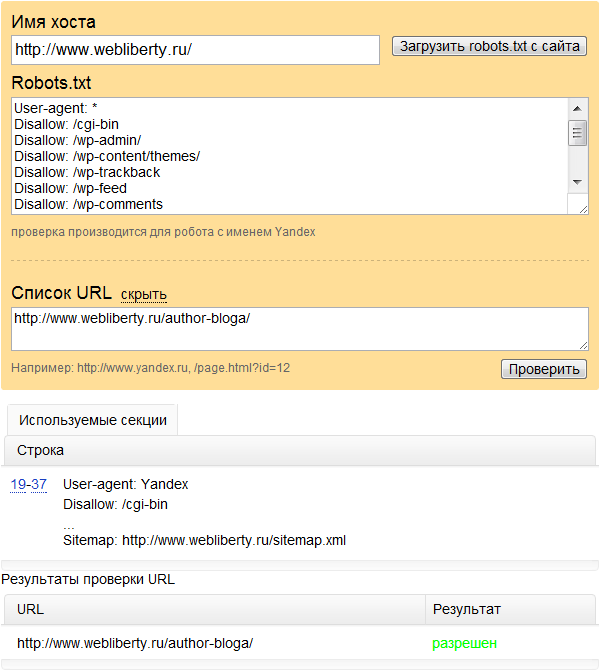

Для проверки доступа робота Яндекса к странице следует пользоваться инструментом под названием Анализ robots.txt из панели Яндекс Вебмастер. Найти его можно по ссылке на главной странице панели ЯВ.

В поле Имя хоста требуется вставить адрес главной страницы и нажать на кнопку Загрузить robots.txt с сайта, после чего содержимое файла будет отображено в текстовом поле ниже. Следующий шаг — добавляем Список URL — по одному адресу на строку и нажимаем на кнопку проверить. Еще ниже появится результат проверки URL — разрешен или запрещен доступ. Таким образом можно проверить правильно ли обрабатываются директивы роботса и все ли лишние страницы закрыты от индексации.

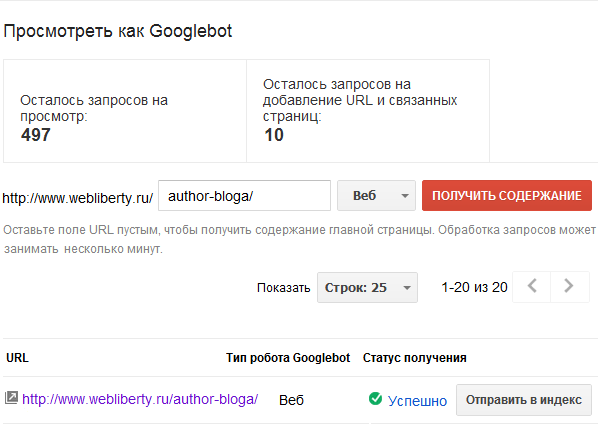

Просмотреть как Googlebot

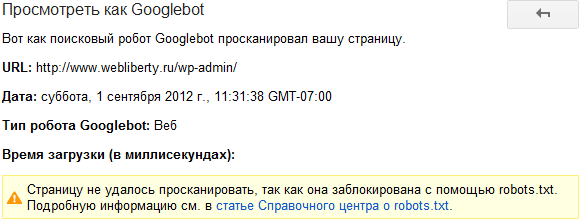

Для проверки доступа робота Google к страницам воспользуемся аналогичным инструментом из панели для вебмастеров, который называется Просмотреть как Googlebot. В текстовом поле вставляем адрес страницы, выбираем тип поискового бота и нажимаем на кнопку Получить содержание. Через несколько секунд запрос будет обработан и указан статус получения — успешно или запрещено в файле robots.txt. Существует ограничение на просмотр страниц: 500 адресов на каждые десять дней.

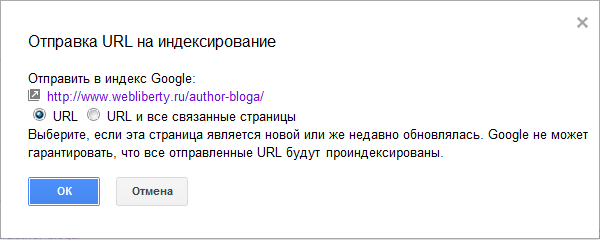

Относительно недавно появилась функция Отправить в индекс — страницу которую отправили на проверку можно отправить на индексацию. При переходе по соответствующей ссылке откроется окно с правом выбора, состоящим из двух вариантов: отправить на индексирование только данный URL или URL и все связанные страницы.

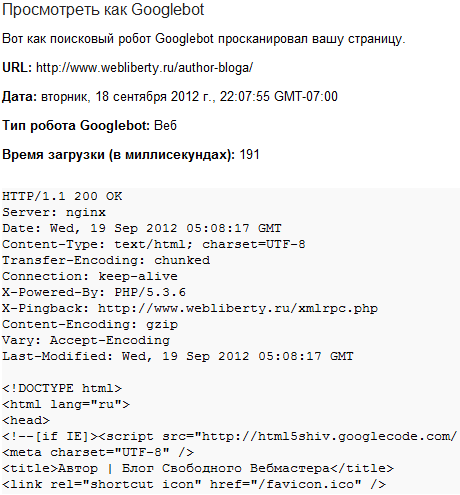

На этом возможности инструмента не заканчиваются. Если запрос выполнен и статус получения содержимого страницы успешный, то перейдя по ссылке «Успешно» мы увидим исходный код страницы таким, каким его видит робот, ответ сервера и время загрузки страницы:

В том случае, если получение содержимого будет запрещено в файле robots.txt, то при переходе по соответствующей ссылке в строке запроса в графе Статус получения видим такой отчет:

Кроме того, используя инструмент Просмотреть как Googlebot у вебмастеров есть возможность выбора типа поискового робота, по-умолчанию используется Веб, весь список такой:

- Веб;

- Для мобильных устройств: XHTML/WML;

- Для мобильных устройств: cHTML;

- Mobile: Smartphone.

Вот все, о чем я сегодня хотел рассказать, есть у Вас есть идеи или предложения для новых тем — пишите на почту, мои контактные данные можно найти на этой странице.

Google не может гарантировать, что ваша страница будет проиндексирована 🙂

Ответить

Поставил интернет-подруге на поддомене Вордпресс, она туда навтыкала статей из интернета — я ей начал долбить про уникальность, написала несколько уникальных статей, решил зарегистрировать сегодня в Яндексе, в роботс все как положено и что же — Яндекс все 26 копий уже 29 сентября проиндексировал, а Гугл одну статью 100% скопированную из Википедии на 18 место из 81 тысячи найденных поставил, не стал другие смотреть, может тоже в топе 😀

Невольно приходит в голову забавная мысль — не из той же ли «оперы», что и глобальное потепление, при аномально холодной зиме и прохладном лете все эти уникальности, валидности, дублированные контенты? 💡

Ответить

Андрей, все верно 🙂 Отправляя страницу на индексирование подразумевается что она открыта для робота и удовлетворяет требованиям поисковой системы, в противном случае она не будет участвовать в поиске.

Юрий, сайт новый и можно предположить что он словил так называемый «бонус новичка», когда страницы нового сайта ранжируются выше, что со временем может пройти. Или же сыграл какой-то фактор, выдвигающий страницу вперед среди прочих равных. Время покажет и расставит все на свои места, однозначно могу сказать, что в дальнейшем качество выдачи будет улучшаться, поэтому следует ставить свою работу таким образом, чтобы не словить нагоняев от ПС 😀

Ответить

Привет, про проверку от google полезно. Кстати, можно проверить страницу, закинув ее в поиск и нажав кнопку «копия» у Яндекс и «Сохраненная копия» у гугл.

Ответить

Добрый день! Подскажите пожалуйста. Я новичок в этих всяких заморочках, пока совсем до конца не разобралась. Как мне добавить свой сайт, что бы индексировались мои страницы? Заранее спасибо.

Ответить

1tasha, во-первых как можно скорее создайте файл robots.txt и настройте правила индексирования, а затем добавьте сайт в поисковые системы через специальные формы. В Гугле сайт уже проиндексирован, а вот Яндекс пока не торопиться.

Ответить